Die größten Profiteure vom AMD-OpenAI Deal

- Lesezeichen für Artikel anlegen

- Artikel Url in die Zwischenablage kopieren

- Artikel per Mail weiterleiten

- Artikel auf X teilen

- Artikel auf WhatsApp teilen

- Ausdrucken oder als PDF speichern

Erwähnte Instrumente

- Arista Networks Inc.Kursstand: 149,500 $ (NYSE) - Zum Zeitpunkt der VeröffentlichungVerkaufenKaufen

- Samsung Electronics (GDR)Kursstand: 1.405,000 € (L&S) - Zum Zeitpunkt der VeröffentlichungVerkaufenKaufen

- Arista Networks Inc. - WKN: A40V33 - ISIN: US0404132054 - Kurs: 149,500 $ (NYSE)

- Samsung Electronics (GDR) - WKN: 896360 - ISIN: US7960508882 - Kurs: 1.405,000 € (L&S)

- Astera Labs - WKN: A404AF - ISIN: US04626A1034 - Kurs: 220,810 $ (Nasdaq)

Ein Milliardenprojekt mit systemischen Nebenwirkungen

OpenAI plant, ab der zweiten Jahreshälfte 2026 rund 1 Gigawatt (GW) an AMDs MI450-Systemen zu installieren, das entspricht etwa 50.000 CoWoS-L-Wafern.

Laut aktuellen Schätzungen liegen AMDs gesamte CoWoS-Bestellungen für 2026 bei 60.000 bis 80.000 Wafern, wovon 80-90 % auf die MI400-Serie entfallen. Damit ist die bestehende Supply-Chain-Planung ausreichend, um OpenAIs 1-GW-Ausbau zu stützen, sowohl unter optimistischen als auch konservativen Annahmen.

Doch Analysten rechnen damit, dass AMD diese Bestellungen im Laufe von 2025 nach oben revidieren dürfte, da sich die Nachfrage nach MI450-Systemen beschleunigt. Besonders profitieren dürfte Samsung, da sie den HBM4-Speicher für die MI450 liefern. Auch wenn die UALink-Spezifikation erst ab der MI500-Serie (2027) in die Massenfertigung geht, profitieren Unternehmen wie Astera Labs bereits früh von der erhöhten Planungssicherheit im Interconnect-Segment.

Altman’s Finesse und die operative Realität

Sam Altmans strategischer Coup verschafft OpenAI zwar mehr Unabhängigkeit von NVIDIA (WICHTIG: Sam Altman stellte zugleich klar, dass dies zusätzlich zur bestehenden Kooperation mit NVIDIA erfolgt. OpenAI plane sogar, die NVIDIA-Käufe künftig weiter zu erhöhen, betonte Altman) doch der operative Hochlauf dürfte holprig verlaufen.

NVIDIAs eigene Erfahrungen mit Rack-Level-Deployments zeigen, wie komplex die Integration von Stromversorgung, Kühlung, Netzwerk und Software-Stack tatsächlich ist. Der Rollout von 1 GW an MI450-Systemen wird daher kaum ohne Verzögerungen ablaufen. AMD muss nicht nur Hardware liefern, sondern auch ein Ökosystem orchestrieren, inklusive ROCm-Optimierung, Ethernet-Kompatibilität und Cluster-Stabilität.

Genau hier spielt NVIDIA seine Erfahrung aus. Während AMD die ersten Systeme integriert, setzt NVIDIA längst zur nächsten Wettbewerbsrunde an: mit neuen Produkten wie Blackwell Ultra und Rubin, einem weiterhin dominanten CUDA-Software-Monopol und einem massiven Ökosystemvorsprung. Solange der Gesamtmarkt für KI-Compute weiter expandiert, bleibt OpenAIs Partnerschaft mit AMD strategisch bedeutsam, aber operativ nicht disruptiv für NVIDIA.

Du willst auch künftig alle Trades & Analysen von Rocco & Valentin live erleben?

AktienPuls360 | Fundi & Charting: Best of Both Worlds

👉 Überzeuge Dich 14 Tage unverbindlich

Im AktienPuls360 habe ich mich mit Rocco Gräfe als Mann mit über 20 Jahren Erfahrung in Charttechnik zusammengeschlossen und wir kombinieren unsere Talente miteinander. Tiefes fundamentales Research & passende charttechnische Einstiege sind keine Traumvorstellung, sondern sind seit Anfang September 2024 Realität.

Drei Depots mit allen Trades, tiefgründige Recherchen, das Experten-Battle Charttechnik vs. Fundamentalanalyse, tägliche Big-Picture-Einordnungen der Märkte und Live-Webinare zu DAX und US-Werten, ...

Ein potenzieller Hintergedanke von OpenAI

OpenAI multisourct bewusst bei NVIDIA, Broadcom, AMD und Google, weil der Open-Source-Stack Triton den Vendor-Lock-in aufbricht: Einmal in einer Python-ähnlichen Sprache schreiben, dann auf unterschiedliche Beschleuniger-Cluster ausrollen, ohne CUDA-, ROCm- oder ASIC-Spezifika.

Der Triton-Softwarestack ist ein Open-Source-Programmierwerkzeug, mit dem Entwickler KI-Modelle effizient für verschiedene Grafikkarten und Beschleuniger schreiben und ausführen können, ganz ohne sich an einen bestimmten Chip-Hersteller binden zu müssen. Das macht KI-Training flexibler, günstiger und unabhängig von CUDA oder anderen herstellerspezifischen Systemen.

Ergebnis: höhere Produktivität, portables Performance-Tuning und die Möglichkeit, heterogene GPU/ASIC-Flotten effizient zu betreiben

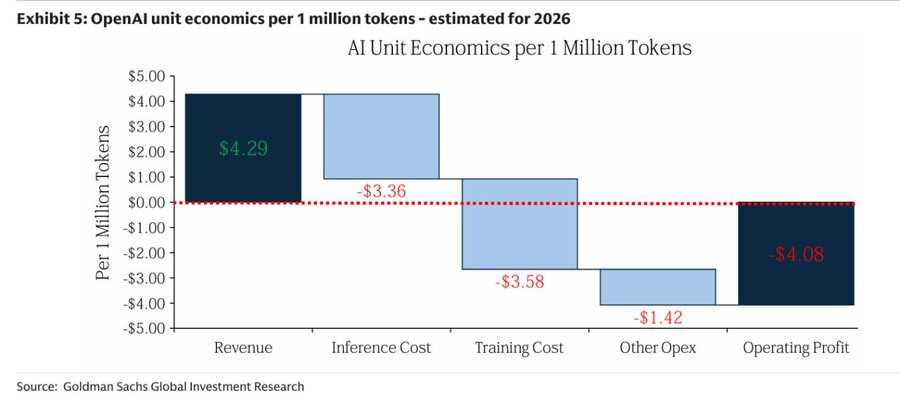

OpenAIs Unit Economics

OpenAI erzielt pro einer Million Tokens etwa 4,29 Dollar Umsatz, hat aber Kosten von über 8 Dollar. Das ergibt für 2026 einen geschätzten operativen Verlust von 4,08 Dollar pro Einheit. Der Grund liegt im immensen Energie- und Rechenaufwand der Inferenzprozesse. Solange sich die Modellarchitekturen nicht drastisch effizienter gestalten, bleibt KI für die Betreiber ein Nullsummenspiel, oder schlimmer: ein subventioniertes Skalierungsrennen.

👉 Aber gegebenfalls hilft u.a. auch das: OpenAI Dev Day wirbelt SaaS-Markt durch. Game-Changer für OpenAI?

Arista Networks: Die leise Revolution in der Interconnect-Schicht

Der eigentliche Paradigmenwechsel spielt sich nicht in den GPUs, sondern im Networking ab. OpenAIs Entscheidung hier, eine AMD-basierte Infrastruktur auf Ethernet statt Nvidias InfiniBand zu bauen. Ethernet-Cluster werden in den kommenden fünf Jahren zum dominanten Standard, mit kumulierten Switch-Umsätzen von 80 Milliarden Dollar. Arista Networks steht dabei an der Spitze dieser Entwicklung.

Aristas 7060X6- und 7800R4-AI-Switches, kombiniert mit Aristas EOS-Betriebssystem, optimieren Latenz, Bandbreitenauslastung und Energieeffizienz. Meta nutzt diese Systeme bereits in produktiven KI-Fabrics. OpenAI, Anthropic und Microsoft dürften folgen. Broadcom liefert mit dem Tomahawk Ultra die Hardware-Basis und verbindet bis zu 256 XPUs in einem Scale-up-Verbund.

Analysten erwarten, dass Aristas KI-bezogener Umsatz von 1,5 Mrd. Dollar 2025 auf 2,75 Mrd. Dollar 2026 steigt. Das Timing ist perfekt: Wenn OpenAIs 1-GW-Cluster online gehen, erreicht Arista die volle Marktdurchdringung seiner 800G-Generation und bereitet bereits den Schritt auf 1,6 Tbit/s vor.

Astera Labs: der frühe Profiteur der UALink-Revolution

Ein Name, der in diesem Kontext häufig übersehen wird, ist Astera Labs. Astera Labs ist einer der wichtigsten Enabler für die entstehende UALink-Ethernet-Architektur, ein offener Hochgeschwindigkeitsstandard, der ab der MI500-Generation (2027) in die Massenfertigung gehen soll.

Astera liefert Connectivity-Lösungen und profitiert damit direkt vom Trend zu offenen Ethernet-Clustern und disaggregierten Compute-Strukturen. Schon bevor AMD seine GPU-Systeme im Volumenmaßstab ausrollt, dürfte Astera Labs durch steigende Nachfrage nach Low-Latency-Bridge-Chips und Smart Cable Modules spürbare Kursimpulse erleben.

Fazit

Der AMD-OpenAI-Deal zeigt, wie stark die Nachfrage nach Compute explodiert, aber auch, wie fragil die Finanzierung dieser Revolution geworden ist. OpenAI kämpft noch mit defizitären Unit Economics, AMD tauscht Eigenkapital gegen Umsatz, und Nvidia konsolidiert seinen Burggraben durch Software und Networking (+ arbeitet schon an physical AI). Arista, Astera Labs, Broadcom und Samsung werden zu den stillen Architekten der neuen Infrastruktur.

Wer auf keinen konkreten Player setzen will - TSMC!

Valentins Depot seit Start im Oktober 2023

Viel Erfolg wünscht Euch Valentin

Passende Produkte

| WKN | Long/Short | KO | Hebel | Laufzeit | Bid | Ask |

|---|

Danke, wieder ausführlich. Kurze Recherche zeigt, dass Marvell auch UALink Chipsets hat und AMD freut sich auf Zusammenarbeit mit Marvell. Wird trotzdem Astera deiner Meinung nach der Hoflieferant sein?