Big Data: Wie der Daten-Tsunami die Märkte verändert

- Lesezeichen für Artikel anlegen

- Artikel Url in die Zwischenablage kopieren

- Artikel per Mail weiterleiten

- Artikel auf X teilen

- Artikel auf WhatsApp teilen

- Ausdrucken oder als PDF speichern

Erwähnte Instrumente

- VerkaufenKaufen

- VerkaufenKaufen

www.cashkurs-trends.de - Testen Sie meinen Börsenbrief!

In der modernen Welt hat vieles zwei Gesichter. Es ist gut, dass Computer und Netzwerke immer stärker in Alltag und Arbeitsprozesse eingreifen. Andererseits besteht die Gefahr, dass die Computerisierung menschliche Erfahrung und Augenmaß verdrängt. Es ist gut, dass wir im Büro mit solch schnellen Kommunikationssystemen wie E-Mail und SocialMedia arbeiten können. Aber immer häufiger hören wir die Klagen von Vorgesetzten, dass die Mitarbeiter in diesem Kommunikations-Tsunami nicht mehr greifbar werden und sich hinter Mails und Postings zu verstecken beginnen. Es ist gut, dass wir in Realzeit mit der ganzen Welt via E-Mail und SocialMedia reden können. Studien des keineswegs technikpessimistischen Massachusetts Institute of Technology (MIT) zeigen jedoch auch, dass durch permanente Kommunikation, Meetings und E-Mail-Kultur Zögern und Unsicherheiten bei wichtigen Entscheidungen immer häufiger übergangen werden. Datenkommunikation wird immer wichtiger. In Zukunft soll die schnelle Datenkommunikation und -nutzung sogar Wettbewerbsvorteile bringen. Big Data ist das Stichwort dafür, dass Daten zur neuen Produktivkraft werden.

1. Was den Zukunftsmarkt Big Data antreibt

Big Data ist ein neuer schillernder Begriff dafür, dass wir in den kommenden Jahren eine neue Welle in der Nutzung von Daten erleben werden. Software-Riesen wie SAP, Oracle, IBM oder Microsoft haben in kurzer Zeit 15 Milliarden US-Dollar in Unternehmen investiert, die sich mit Big Data beschäftigen.

Aber wie kann das Sammeln und Auswerten von Daten tatsächlich zu einem Produktivitätsfaktor werden? Für Marketing- und Vertriebsprozesse bringt Big Data den folgenden nicht zu unterschätzenden Vorsprung. Schauen wir uns dafür ein fiktives Beispiel an: Suchten Marketingabteilungen früher Daten zu grünäugigen Bäckern in Heidelberg, mussten alle Zeilen einer Datenbank nach jeder einzelnen Übereinstimmung mit dieser Abfrage durchsucht werden. Mit Big-Data-Lösungen werden erst alle Personen in Heidelberg gesucht, dann alle Bäcker darunter und schließlich werden die grünäugigen darunter herausgefiltert. Ein enormer Geschwindigkeitszuwachs in der Suche. Wer seine Kunden zielsicher erreichen will, könnte also bald mit Big Data glücklich werden.

Unbestritten ist, dass das Geschäft mit Analyse- und Steuerungsprogrammen von gigantischen Datenmengen, die mittlerweile im Petabyte-Bereich (1.000.000.000.000.000 Byte) liegen, vor einer dynamischen Wachstumsperiode steht. Unternehmen, von Umsatzerwartungen unter Druck gesetzt, denken immer häufiger um. Statt Bauchgefühl soll nach Möglichkeit ein ausgefeilter Algorithmus entscheiden. Big Data verspricht noch präzisere Daten, erhoben in Realzeit, so dass wichtige Entscheidungen immer weniger irrtumsanfällig werden. Eine große Verlockung, gar eine Utopie. Doch schauen wir genauer hin.

Um zu sehen, auf welche Bedürfnislagen der Zukunftsmarkt Big Data abzielt, ein paar Beispiele:

■Walmart, der weltweit größte Einzelhändler, wickelt rund eine Million Transaktionen ab - in einer Stunde an einem normalen Einkaufstag. Diese Daten werden auf Server gepackt, die auf eine gigantische Datenkapazität von 2,5 Petabytes kommen. Das entspricht der 167-fachen Menge an Daten, die in Buchform in der amerikanischen Library of Congress aufzufinden sind.

■Facebook muss täglich mit rund 250 Millionen Fotos umgehen, die von den Nutzern des SocialMedia-Netzwerks hochgeladen wurden.

■Es dauerte zehn Jahre, bis das menschliche Genom entschlüsselt werdenkonnte. Heute könnte diese Rechnerleistung im Lauf einer Woche bewerkstelligt werden.

Daten scheinen uns zu erdrücken, statt uns zu nutzen. Für alle Daten, die in zehn Jahren auf der Welt kursieren werden, das haben Wissenschaftler errechnet, bräuchte man einen DVD-Stapel, so hoch wie die Strecke von der Erde bis zum Mars. Big Data könnte den Grundstein dafür legen, dass wir angesichts dieses Daten-Tsunamis möglicherweise klüger werden und unsere Geschäfte effizienter abwickeln. Big Data wird von den Marktforschern aus dem Hause Gartner zu den zehn Schlüsseltechnologien der kommenden Jahre gezählt. Im vergangenen Jahr wurden im Silicon Valley allein über 150 Startups gezählt, die sich mit Big Data befassen. Venture Capital (VC) Firmen setzen beachtliche Summen ein auf diesem Sektor. Die Firma Accel Partners, ein VC mit fast neun Milliarden Spielkapital, hat einen eigenen Fond in Höhe von 100 Millionen US-Dollar eingerichtet und bereits in 15 Big-Data-Unternehmen investiert.

Gut und Böse liegen bei der Zukunftstechnologie Big Data eng beieinander

Glaubt man den Big-Data-Pionieren, geht es für die Unternehmen, die auf Big Data zurückgreifen, in Zukunft um das Heben eines digitalen Schatzes, des Schatzes der so genannten „unstrukturierten“ oder „non-relationalen“ Daten. Das sind Daten, die in Unternehmen bislang nicht systematisch untersucht und ausgewertet wurden: Weblogs, Facebook, Twitter, eMails, Fotos, sogar Daten aus Sensoren, Stromnetzen und Leitungssystemen.

Die Frage, die sich jedoch spätestens an dieser Stelle erhebt: Werden wir durch Big-Data nicht endgültig zu einer Big-Brother-Gesellschaft, in der jede Zuckung der „Endverbraucher“ überwacht und zu Marktforschungszwecken durchleuchtet wird? Hält damit der laxe Umgang mit der Privatsphäre à la Facebook nicht auf breiter Front Einzug? Der Ansatz hinter Big Data hat zunächst nichts mit dem Unwesen von Datenkraken wie Google und Facebook zu tun. Facebook und Google versuchen ziemlich unverhohlen, möglichst viele und möglichst intime Daten von Nutzern an die Werbung zu verkaufen, die insbesondere Facebook mit dem Versprechen auf sein Portal lockt, sich selbst darstellen und seine Anliegen (vermeintlich) einem Weltpublikum vorstellen zu können.

Auch für die kommende Big-Data-Welle zeichnet sich ab, dass zunächst wieder einmal die Technologie die Fakten schaffen wird und Gesetzgebungsmaßnahmen sowie die gesellschaftliche Debatte hinter der Musik her rennen werden. Die Verlautbarungen seitens der EU (unter anderem von Neelie Kroes, niederländische EU-Kommissarin für die „Digitale Agenda“) zeigen, dass die Gefahren des Daten-Tsunamis erkannt werden. Big Data, das in der westlichen Welt zur zivilen Nutzung eingesetzt wird, kann in diktatorischen Regimen zur Überwachung der Bevölkerung eingesetzt werden. Auch Hillary Clinton, amtierende US-Außenministerin, betonte auf der iFreedom-Konferenz im Dezember 2011 in Den Haag die Gefahren eines fließenden Übergangs zwischen Big Data und Big Brother.

Keine Frage, ein rasanter Trend wie Big Data verlangt einen verantwortungsvollen Umgang. Einstweilen werden die Grenzen des Zulässigen und Schicklichen ausgetestet. Zu den tendenziell bösen Buben, für die Big Data nur ein weiterer Hebel zur Komplettüberwachung von Kundenverhalten ist, gehört unseres Erachtens auch Amazon. Der Online-Buchhändler hat Anfang Dezember ein Patent eingereicht, wie Nutzer anhand ihres Mobiltelefons identifiziert werden können und aus den individuellen Bewegungsdaten Prognosen abgeleitet werden, welche Kaufhäuser und Läden der Nutzer in naher Zukunft besuchen wird. Entsprechend könnten diese Läden den Nutzer dann mit personalisierten Werbebotschaften ansprechen oder ihn mit Gutscheinen locken. Ist eine solche Form der Personalisierung noch kundenfreundlich oder die Vorstufe zu einem Überwachungssystem? Vorläufig gibt es keine gesetzlichen Vereinbarungen, die Licht in diese Grauzone bringen.

Es gibt aber auch die Guten, die Big Data nutzen, um an den Schlüsselproblemen unserer Welt zu arbeiten und Zukunftstechnologien auf den Weg zu bringen. Vestas beispielsweise, der weltgrößte Hersteller von Windkraftanlagen, nutzt intensiv Big-Data-Software von IBM. Wind ist ein instabiler Energieträger. Um aus der Windenergie für die Kunden ein Geschäft zu machen, muss Vestas mit einer Unmenge an Informationen umgehen: Nicht dort, wo der Wind am stärksten ist, ist es sinnvoll Windkraftanlagen aufzustellen. Außerdem: Nur wer die Produktion von Strom durch Windkraft mit modernsten Technologien und auf Basis präziser Daten betreibt, bleibt auf dem Zukunftsmarkt der alternativen Energien konkurrenzfähig. Vestas bearbeitet all diese Fragestellungen auf der Basis von gigantischen Datenmengen - Big Data. IBM hat sein Big-Data-Konzept darüber hinaus in der Gesundheitswirtschaft erfolgreich eingesetzt. Infektionen von Neugeborenen konnten in einem kanadischen Klinikprojekt mithilfe von Big Data 24 Stunden früher diagnostiziert werden. Und Sekunden können in der Medizin Leben retten, IBMs Big Data für Kliniken liefert diesen zeitlichen Vorsprung durch Realzeit-Datenanalyse. Laut IBM konnte in Kliniken die Patientensterblichkeit um 20 Prozent durch in Realzeit gestreamte Patientendaten gesenkt werden.

Für Unternehmen, die jeden Wettbewerbsvorteil ausschöpfen möchten, liegen die Vorteile von Big Data auf der Hand:

* Big Data verspricht nicht nur die Ansammlung von großen Datenmengen, es verspricht endlich eine effektivere Nutzung von Daten.

* Big Data verspricht Datenerhebung und Analyse in Realzeit, ohne dass die Daten lange auf Servern hin und her bewegt und geladen werden müssen.

* Big Data verspricht auf der Basis neuer Software eine intelligentere Verknüpfung von Firmendaten, so dass speziell Kundendaten besser verstanden und in effektivere Produktstrategien umgesetzt werden können.

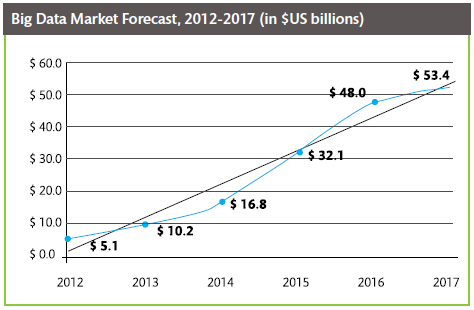

Der Markt für Big Data wird jährlich um 40 Prozent anwachsen. Das entspräche der siebenfachen Wachstumsrate des gesamten ICT-Markts. Bereits im Jahr 2015 werde der Umgang mit dem Datenwust ein Marktvolumen von 16,9 Milliarden US-Dollar generieren, prognostizieren die Marktforscher von IDC in einer aktuellen Studie („Big Data Analytics in Deutschland 2012“). Big Data kommt seit einigen Jahren zumeist bei Großfirmen in der Kundenakquise zum Einsatz. Wer wie Großbanken jährlich 50 Millionen Postsendungen verschickt, kann über Big Data die Inhalte genauer auf die Empfänger abstimmen, indem nicht nur die Rücklaufquote quantitativ erfasst, sondern auch qualitativ ausgewertet wird.

Natürlich verspricht Big Data, auch Kosten sparen zu helfen. Großfirmen investieren schon seit Jahrzehnten Millionenbeträge in die Pflege und Analyse ihrer Stammdaten. Mit Hilfe von neuen Software-Produkten, das behauptet der Big-Data-Spezialist Camelot, lassen sich 20 Prozent dieser Kosten sparen. Camelot versorgt Großunternehmen mit großen Datenplattformen, auf denen Lieferanteninformationen zentral gespeichert werden. Je einfacher und klarer die Übersicht, so ein Credo von Big Data, umso niedriger die Kosten, umso schneller die Prozesse, umso effizienter die Absatzplanung.

Der innovative Kern von Big Data: Durch Datenintegration werden aus riesigen Datenmengen zielführende Informationen destillierbar, wodurch sich die Art und Weise der Informationsnutzung in Unternehmen signifikant verändern wird. Dies bedeutet praktisch, dass durch Big Data pro Sekunde Petabytes an Daten von quasi jedem angeschlossenen Gerät aus gefiltert und analysiert werden können, selbst während sich die Bytes noch in Bewegung befinden.

2. Die Roadmap: Der Zukunftsmarkt Big Data

Wer in den kommenden Jahren Algorithmen dafür liefert, dass Kundenbedürfnisse besser verstanden werden können, der wird auf dem Big-Data-Markt weit vorne liegen. Großunternehmen aus der Medienbranche suchen gerade händeringend nach Softwarelösungen, um Kundendaten besser verstehen können. Der US-Videoverleiher Netflix schrieb kürzlich ein Preisgeld von einer Million US-Dollar für einen Algorithmus aus, mit dem er Kunden noch passendere Filmvorschläge machen kann. Ob Action, Romantik oder Komödie - der Sieger-Algorithmus, so ist zu hören, trifft den Geschmack der Kunden um exakt 10,06 Prozent besser als die Vorversion.

Supermärkte bestellen längst ihre Waren aufgrund von Nachfragekurven und Einkaufsverhalten, Onlinevermarkter schalten Werbung auf der Basis gespeicherter Konsum- und Suchprofile. Viele Daten werden künftig aus Sensoren kommen – sie werden bislang jedoch äußerst selten oder nur sehr ineffizient genutzt. Maschinen, Stromzähler, intelligente Häuser oder Funketiketten liefern permanent Informationen, die wertvolle Aufschlüsse zur Optimierung Ihrer Kernprozesse geben könnten. Voraussetzung dafür sind neue Technologien, die neue Analyseansätze liefern: Big Data.

Die drei in der IDC-Studie am häufigsten genannten Einsatzfelder für Big Data sind die Verbesserung des Kundenservice, IT-Analyse und eine bessere Unternehmenssteuerung.

Genauer betrachtet wird sich Big Data folgendermaßen auf die Märkte in der Zukunft auswirken:

* IT-nahe Branchen werden zuerst profitieren:Von Haus aus IT-affine Branchen werden zuerst von der Big-Data-Welle profitieren. Dazu gehören Computer- und Elektronikindustrie, Finanzdienstleistungen, der Handel (e-Commerce und stationär), natürlich auch der Bildungssektor und das Versicherungswesen, aber auch die öffentlichen Verwaltungen. Mittelfristig, so die Expertenmeinung, wird Big Data als markanter Wettbewerbsvorteil in alle Branchen vordringen.

* Prozesse werden in Realzeit optimiert (Fehlkalkulationen früher erkannt):Big Data wird die Wertschöpfung auf vielen Märkten ankurbeln, weil die neuen Software-Produkte Informationen immer schneller, mithin in Realzeit zugänglich machen und so Prozesse optimieren helfen.

* Direktere Steuerung von Innovationen:In dem Maße, wie Unternehmen mit Hilfe von Big Data immer mehr und immer schneller Daten über Kunden, Umsätze und Mitarbeiter erheben, lassen sich immer schneller Schlüsse ziehen und Entscheidungsprozesse korrigieren. Unternehmen können in immer kürzeren Zeitabständen Versuchsreihen beispielsweise zu Produktneuheiten starten und in Realzeit bewerten.

* Marktforschung in Realzeit:Zweifellos könnte durch Big Data schon in einigen Jahren eine Revolution der Marktforschung anstehen. Wenn gerade über digitalen Konsum, beziehungsweise Smartphone-Nutzung immer mehr Nutzerdaten vorliegen, lassen sich auch immer präzisere Nutzersegmentierungen austüfteln.

* Produktgenerationen lernen schneller voneinander:Selbstredend lassen sich auf Basis von Big Data Produktgenerationen vorstellen, die ungleich schneller voneinander lernen. In Neuprodukten eingebaute Microchips informieren dann in Realzeit über Nutzungsformen, Lebensdauer und Versorgungslücken im Lebenszyklus eines Produktes.

Ein weiterer Pferdefuß in der schönen neuen Datenwelt, der indes nicht unter den Tisch gekehrt werden darf: Während die Datenanalyseprogramme immer intelligenter werden, ist in den kommenden Jahren erst einmal mit einem Big-Data-Fachkräftemangel in Nordamerika und Europa zu rechnen. Big Data weckt große Phantasien, was den kreativen Umgang mit Daten angeht - auf kurze Sicht fehlt jedoch die Manpower, die Datenschätze angemessen zu heben.

Wie sieht aktuell der Big-Data-Markt aus? Einer Untersuchung von Wikibon zufolge hat IBM zurzeit die größten Marktanteile inne, Umsatz mit Big Data knapp über einer Milliarde US-Dollar. Intels Big-Data-Umsätze liegen bei 765 Millionen US-Dollar, womit Intel auf Platz zwei landet. HP belegt Platz drei mit Big-Data-Umsätzen von rund 550 Millionen US-Dollar. Wohlgemerkt: Big Data eröffnet neue Wege, mit Daten Wettbewerbsvorteile einzuheimsen - doch bislang liegen die Umsätzen der genannten Großunternehmen gerade einmal bei einem Prozent des Gesamtumsatzes. In den vergangenen Jahren ist jedoch speziell in den USA eine lebendige Kultur an Startup-Unternehmen entstanden, die sich dem Trendthema Big Data verpflichtet fühlt.

Wikibon hat auch diese Unternehmen unter die Lupe genommen, allesamt junge Projekt, die mit Big Data schon jetzt mehr als die Hälfte ihres Gesamtumsatzes erwirtschaften. Die Übernahmeschlachten auf dem boomenden Markt des Daten-Handlings haben offenbar gerade erst begonnen. Drei der vier größten US-Big-Data-Startups wurden bereits von einem Software-Giganten geschluckt. Vertica (Big-Data-Umsatz von 84 Millionen US-Dollar), gehört seit 2011 zum HP-Imperium. Aster Data, (52 Millionen Jahresumsatz mit Big Data, wurde im März 2011 von Teradata aufgekauft. Und Greenplum (43 Millionen US-Dollar mit Big-Data-Produkten) ist seit Sommer 2010 im Besitz von EMC.

Andere Big-Data-Spezialisten wie 1010Data (30 Millionen US-Dollar mit Big Data), Think Big Analytics (acht Millionen US-Dollar), MapR (sieben Millionen US-Dollar), und Digital Reasoning (sechs Millionen US-Dollar) bestreiten deutlich mehr als 50 Prozent ihres Umsatzes mit Big Data. Die Zukunft des Datenmanagements - nennt man es nun Big Data oder nicht - wird nicht mehr in der Anhäufung, sondern dem erweiterten Verstehen von Realzeitdaten bestehen.

3. Die Unternehmen

Big Data löst gerade die nächste Akquisitions-Welle aus. Der Markt befindet sich in einer Aufbruchsphase. Hier die interessantesten Unternehmen, über die wir in den nächsten Jahren mit Sicherheit reden werden:

* IBM (www.ibm.com): Weltrettung mit Big Data statt PC-Verkauf

Im Gegensatz zu Firmen wie Facebook zeigt sich IBM als ein Unternehmen mit Charisma und Vision über die eigene Branche hinaus. IBM setzt seine Erfahrung in Netzwerktechnologie konsequent für die Lösung globaler Probleme ein. Mit IBM ist aus einem Computer-Unternehmen Stück für Stück ein Weltkonzern geworden, der sich mit Vernetzung im Büro und Social Media ebenso beschäftigt wie mit Urbanisierung („Smart Cities”), Klimawandel („Big Green Innovations ”) und intelligenten Wassermanagement-Systemen. Big Data, so die Philosophie von IBM, wird gerade hier bahnbrechende Lösungen anbieten können. Die veralteten Wasserleitungssysteme speziell in den USA, aber auch in Europa, werden in den nächsten Jahren erneuert – ein gigantischer Markt. IBM unterstützt die Kommunen in San Francisco und Washington dabei, eine effizientere Wasserwirtschaft aufzubauen. Bis zu 50 Prozent des Wassers gehen dort beim Transport verloren. IBM hat Big-Data-Technologien entwickelt, die dabei helfen, die Lücken in den Systemen aufzuspüren. Großen Schwung ins Big Data-Geschäft von IBM brachte außerdem die Akquisition von Netezza. Der Datenbank-Spezialist wurde im Herbst 2010 von IBM aufgekauft. Ein Drittel der Umsätze, die Netezza nach der Heirat mit IBM erzielte, gingen auf das Konto von lupenreinen Neukunden. Seit dem Netezza-Kauf wuchs darüber hinaus die Neukunden-Datenbank der IBM-Tochter um stattliche 40 Prozent. Als wichtigste heute schon verfügbare Komponenten nennt IBM im Zusammenhang mit Big Data das Produkt InfoSphere BigInsights. Es ermöglicht große Mengen von strukturierten und unstrukturierten Daten zu speichern und zu analysieren. IBM gehört mit einem Umsatz von 106,9 Milliarden US-Dollar im Jahr 2011 zu den weltweit größten Anbietern in der Informationstechnologie (Hardware, Software und Services) und B2B-Lösungen. Das Unternehmen beschäftigt derzeit über 400.000 Mitarbeiter und ist in über 170 Ländern aktiv. Im Dezember 2004 verkaufte IBM sein PC-Geschäft an Lenovo und erklärte die PC-Ära für beendet.

* Splunk (www.splunk.com): Das Google der Big-Data-Szene

Die erfolgshungrigen amerikanischen Medien sprechen angesichts von Splunk bereits von dem „Google der Big-Data-Branche“. Die Splunk-Aktie explodierte beim IPO im April 2012 und verdoppelte gleich am ersten Tag seinen Ausgangspreis von 17 US-Dollar. Splunk ist Anbieter von Big-Data-Software, mit der Echtzeit-Computerdaten vor Ort oder in der Cloud überwacht, analysiert und in Berichten dargestellt werden. Das Alleinstellungsmerkmal des jungen Unternehmens liegt jedoch darin, Maschinendaten leicht und in Realzeit lesbar zu machen. Nach Angaben des Unternehmens nutzen bereits mehr als 3.700 Unternehmen, Dienstanbieter und Behörden in 75 Ländern die Softwareprodukte von Splunk. Das Unternehmen, das im Jahr 2004 in San Francisco gegründet wurde, ist der erste Börsengang eines auf Big Data spezialisierten Startups. Es ist davon auszugehen, dass in den kommenden zwölf Monaten keine weiteren IPOs Splunk folgen werden. Splunk konnte sich zu Beginn des Jahres noch einmal 15 Millionen US-Dollar von Investoren sichern. Splunk erzielte im Fiskaljahr 2012 einen Umsatz von 121 Millionen US-Dollar, was einem Zuwachs von 83 Prozent entspricht.

* NetApp (www.netapp.com): Big Data als Effizienz-Werkzeug

NetApp bietet Big-Data-Lösungen, die große Datenmengen effizient verarbeiten (zum Beispiel Video-Streaming), analysieren und managen. Analyse für großen Datenmengen, Bereitstellung von hoher Bandbreite und Content (sicheres Datenmanagement) - das sind die drei Säulen des Erfolgsmodells von NetApp. Das Unternehmen aus Sunnyvale, Kalifornien, verspricht die folgenden greifbaren Lösungen für Kunden: Reduzieren des Datacenter-Aufwands um 50 Prozent, Steigerung der Speicherauslastung um 200 Prozent und der Storage-System-Performance um bis zu 400 Prozent. Wer auf Big Data aus dem Hause NetApp setzt, so das vollmundige Versprechen, darf sich auf einen Return on Invest von bis zu 166 Prozent durch seine Datencenterumstellung freuen. Wichtige Zukäufe von NetApp: 2008 Onaro (Datenmanagementsoftware), 2011 Akorri (Datenmanagementsoftware), 2011 Engenio (Cloud-Lösungen). Das „Great Place to Work Institute“ kürte NetApp kürzlich auf Platz drei seiner Liste der „World’s Best Multinational Workplaces 2011“ – der weltweit umfangreichsten Umfrage zur Arbeitsplatzqualität. NetApp erzielte im Geschäftsjahr 2011 einen Gesamtumsatz von 5,123 Milliarden US-Dollar.

* SAP (www.sap.com): Mit „Hana“ in die Daten-Realzeit

Das Software-Unternehmen aus dem badischen Walldorf arbeitet mit Hochdruck an der Beschleunigung von Datenmanagement-Systemen. Neuestes Produkt dabei ist „Hana“, eine High Performance Analytic Appliance, die es Unternehmen erlaubt, Daten in Realzeit zu analysieren. „Hana“ verarbeitet gigantische Datenmengen im Handumdrehen. Der Trick dabei: Die Daten werden schlicht im Arbeitsspeicher (RAM) abgeladen und dort direkt weiter verarbeitet, statt sie erst auf (langsameren) Laufwerken abzulegen und von dort wieder laden zu müssen. So können in Sekunden locker 360 Millionen Datensätze nach gesuchten Angaben durchforstet werden. Hana ist seit Juli 2011 bei Hardware-Partnern wie Hewlett Packard verfügbar. SAP wirft sein Auge immer stärker auf Kunden aus dem Mittelstand. „Hana“ wurde - in guter alter Tradition - zunächst für Großkunden entwickelt. Nach der Sommerpause 2012 gibt es „Hana“ auch für Mittelständler („Hana for SMB“). Der Umsatz von SAP kletterte im Geschäftsjahr 2011 um 14 Prozent auf 14,23 Milliarden Euro.

* Oracle (www.oracle.com): Simplify your data!

Der Business-Intelligence-Gigant aus Amerika preist seine Big-Data-Vorstöße unter dem Stichwort „Simplifying“ an. Nur dasjenige Unternehmen positioniert sich innovativ, das Herr über seine Daten ist, so das Credo. Oracle verfügt weltweit über 65.000 Kunden. Ausnahmslos alle Unternehmen unter den Fortune 100 greifen auf Oracle-Software zurück. Das Unternehmen aus dem Silicon Valley machte im Geschäftsjahr 2011 einen Umsatz von 35,6 Milliarden US-Dollar. Mit der Übernahme von Sun Microsystems 2009/2010 hat Oracle sein Angebot auf Java, Linux-Technologien Entwicklungswerkzeuge sowie eine Open-Source-Datenbank erweitert. Mittelfristiges Ziel ist es, als Komplettanbieter Unternehmen wie Apple oder Cisco Konkurrenz zu machen.

* Teradata (www.teradata.com): Erfahrener Big-Data-Pionier

Das Unternehmen aus Atlanta bezeichnet sich selbst als den weltweit größten Anbieter von analytischen Datenbanksystemen. Mit dem Kauf von Aster Data vor zwei Jahren hat sich Teradata einen ausgeprägten Spezialisten für die Analyse unstrukturierter Daten ins Haus geholt. Teradata hat seine Kundenbasis in den vergangenen vier Jahren um 50 Prozent erhöht. Teradata wird in den USA die Leistung zugeschrieben, Big Data aus der Nische der e-Commerce- und Handelskunden herausgeholt und für den Massenmarkt zugänglich gemacht zu haben. Das bereits 1979 gegründete Unternehmen gilt seit längerer Zeit als Hidden Champion der IT-Branche und taucht regelmäßig als Übernahmekandidat auf. Seit 2008 schießen in Endlosschleife Gerüchte ins Kraut, wonach Teradata ein Kaufkandidat für Hewlett Packard oder SAP sein könnte. Neben Big Data und Cloud-Themen liefert das Unternehmen immer wieder auch neue Produkte auf einem Perspektivmarkt wie dem „Internet der Dinge“ (Kommunikation von Maschine zu Maschine). Teradata erzielte im Geschäftsjahr 2011 ein Umsatz von 2,362 Milliarden US-Dollar.

* Cloudera (www.cloudera.com): Big Data als Abonnement

Cloudera könnte das nächste Unternehmen sein, dass als Big-Data-Spezialist den Börsengang wagt. Cloudera sammelte Ende 2011 40 Millionen US-Dollar bei Investoren ein. Cloudera arbeitet wie die meisten Big-Data-Firmen mit der Open-Source-Software Hadoop und unterstützt unter anderem Nokia, Qualcomm (Mobilfunktechnologie) und Groupon dabei, ihre gigantischen Datenmengen zu analysieren. Cloudera hat in den vergangenen Jahren seinen Umsatz und die Mitarbeiterzahl verdoppelt. Das Unternehmen aus dem kalifornischen Palo Alto beschäftigt aktuell 220 Mitarbeiter. Clouderas Geschäftsmodell basiert auf einem Abonnentensystem, das loyale Kunden und sichere Umsätze verspricht. Aktuelle Umsatzzahlen des Unternehmens ließen sich nicht ermitteln.

* Software AG (www.softwareag.com): Big-Data-Kompetenz lange vor dem Hype

In den letzten drei Jahren akquirierte die Software AG sieben IT-Firmen mit einem Transaktionsvolumen von über 1,2 Milliarden US-Dollar und mehr als 4.000 Mitarbeitern, wie z. B. webMethods - ein Marktführer in Integrationstechnologie und BPM, sowie IDS Scheer, der Marktführer in Prozessmodellierung. Die Software AG hat Produkte für den Big-Data-Bereich hergestellt, bevor der Begriff auf dem Markt war: Mit Adabas (weltweit erste transaktionale Hochleistungsdatenbank) und ARIS (erste Plattform zur Analyse von Geschäftsprozessen) hat sich das Unternehmen auf dem Zukunftsmarkt positioniert. Mit einem Umsatz von knapp 1,1 Milliarden Euro hat die Software AG das Rekordergebnis des Vorjahres bestätigt. Laut „Business Week“ ist die das Unternehmen mit dem weltweit siebtschnellsten Wachstum. Die Software-Schmiede beschäftigt weltweit 5.500 Mitarbeiter. In den vergangenen vier Jahren stieg der Umsatz des Darmstädter Unternehmens um satte 75 Prozent.

* EMC (www.emc.com): Auf dem Weg zum virtuellen Unternehmen

Mit dem Kauf von Greenplum hat EMC gerade noch rechtzeitig den Aufsprung auf den Big-Data-Zug geschafft. Dadurch hat sich das Unternehmen Zugang zur Herstellung von Software-Produkten für die Realzeit-Analyse von Daten verschafft. EMC bietet Produkte und Services, die Menschen und Unternehmen auf der ganzen Welt dabei helfen, durch die Erstellung von Informationsinfrastrukturen vom maximalen Nutzen ihrer Daten zu profitieren. Zusammen mit Cisco und VMware treibt EMC im Rahmen der Virtual Computing Environment Coalition (VCE) die Entwicklung und Realisierung von effizienten, durchgängig virtualisierten Informationsinfrastrukturen voran. EMC hat in den vergangenen Jahren mehr als 40 Software- und Service-Firmen akquiriert. Derzeit beschäftigt EMC rund 50.000 Mitarbeiter weltweit, 40 Prozent davon außerhalb der USA. Mit bis zu 400 Vertriebsstellen und Partnern in mehr als 60 Ländern ist das Unternehmen international präsent. EMC gilt unter amerikanischen Analysten als eine Top-3-Wahl unter den interessantesten Unternehmen für Big Data und Cloud Computing. EMC schloss das Geschäftsjahr 2011 mit einem Rekordumsatz von 20 Milliarden US-Dollar ab, was einem Zuwachs von 18 Prozent gegenüber dem Vorjahr entspricht.

* Informatica (www.informatica.com): Datenintegration in der Cloud

Das Unternehmen wurde 1993 im Silicon Valley von den indischen Unternehmern Gaurav Dhillon und Diaz Nezamoney gegründet. Es entstand aus der Idee, dass Datawarehouses nicht mehr in Handarbeit eingelesen werden sollten, sondern mit grafischen Werkzeugen erstellt werden können. Informatica verfügt weltweit über 4.630 Kunden. Informatica offeriert Software und Datenbanklösungen, die es erlauben, Datenbestände innerhalb oder außerhalb des Unternehmens oder in der Cloud abzurufen, zu integrieren und zu analysieren. Ein Produkt wie das Informatica PowerCenter gestattet es, vollkommen formatunabhängig die Integration von Daten aus praktisch allen Unternehmenssystemen, damit diese Daten dann im gesamten Unternehmen beliebig schnell bereitgestellt werden können. Im zweiten Quartal 2011 erwirtschaftete Informatica einen Umsatz in Höhe von 192,7 Millionen US-Dollar.

* SAS (www.sas.com): Die Visualisierung von Big Data

SAS stellt Software für Data-Mining, Data-Warehouse-Lösungen und Business-Intelligence her. Darüber hinaus entwickelt das Unternehmen aus Cary, North Carolina, Software für das IT-Management, die für das IT-Performance Management, IT Capacity Management, IT Scorecard und das IT Controlling eingesetzt wird. Dass sich SAS seit einigen Jahren intensiv auch mit Big Data beschäftigt, versteht sich von selbst. SAS surft auf der Big-Data-Trendwelle vor allem über beeindruckende Visualisierungssoftware. Das Produkt „Visual Analytics“ beispielsweise liefert einen Designer für individuelle Dashboards und einen mobilen Client für das iPad. Mit Produkten wie SAS High-Performance Analytics und SAS High-Performance Risk hat SAS seit dem Ende des vergangenen Jahres zwei neue Anwendungen am Start, die speziell zur schnellen Analyse extrem großer Datenmengen und für das Risikomanagement herangezogen werden können. Der weltweite Umsatz von SAS stieg im Geschäftsjahr 2011 um zwölf Prozent auf 2,725 Milliarden US-Dollar. SAS ist das größte nicht an der Börse notierte Softwareunternehmen der Welt.

4. Ausblick/Prognose

Wie es sich für einen substanziellen Trend gehört, wird Big Data die Märkte, unsere Arbeitswelt und unsere Gesellschaft verändern. Wir können uns diesem Trend nicht entziehen. Wir haben jedoch jetzt die Möglichkeit, rechtzeitig die Rahmenbedingungen für den kommenden Daten-Tsunami zu bestimmen. Diese Arbeit muss von den Unternehmen, die Big Data anbieten ebenso bewältigt werden wie von den Unternehmen, die von den Segnungen von Big Data profitieren. Und natürlich brauchen wir so schnell wie möglich eine politische und juristische Auseinandersetzung über Big Data.

McKinsey hat Ende 2011 prognostiziert, dass schon jetzt fünf Prozent der weltweiten Ausgaben für IT auf das Konto von Big-Data-Anwendungen gehen, Tendenz dynamisch ansteigend. Die Produktivitätsfaktoren auf den Märkten der Zukunft werden Arbeit, Kapital und ab sofort auch intelligent aufbereitete Daten sein. Bereits 2009 verfügte laut einer McKinsey-Studie im Durchschnitt jedes US-Unternehmen (mehr als 1.000 Mitarbeiter) über einen Datenbestand von 200 Terabytes. Das entspricht der doppelten Größe, über die die gigantische Datenplattform von WalMart im Jahr 1999 verfügte. Big Data ist längst ein Faktum - es kommt jetzt darauf an, die kulturellen und rechtlichen Rahmenbedingungen dafür festzuzurren. Der Fachkräftemangel auf dem Gebiet der Big Data sollte nicht nur als Wachstumshemmnis gesehen werden. Wenn es nicht schnell gelingt, menschliche Fachkompetenz hinreichend für das Big-Data-Abenteuer zur Verfügung zu stellen, könnte es passieren, dass der Schuss nach hinten losgeht. Das Ergebnis wäre eine Ära der Daten-Panscherei, bei der jeder private Fleck von Daten erfasst wird, aber niemand wirklich Nutzen aus dieser Big-Brother-Situation zieht.

Die Privatwirtschaft betrachtet Big Data mit Recht zunächst einmal als Chance: zur Absatzsteigerung und Vermeidung von Streuverlusten in der Werbung, aber auch zur Angebotsoptimierung in der Versicherungsbranche und zeitnäherer Beobachtung von Marktschwankungen in der Finanzwirtschaft. Naivität und Vogel-Strauß-Politik werden die Kunden auf mittlere Sicht aber - hoffentlich!- nicht dulden.

Dr. Eike Wenzel, Institut für Trend- und Zukunftsforschung

Passende Produkte

| WKN | Long/Short | KO | Hebel | Laufzeit | Bid | Ask |

|---|

Keine Kommentare

Die Kommentarfunktion auf stock3 ist Nutzerinnen und Nutzern mit einem unserer Abonnements vorbehalten.